5 начина да се премахне страницата от търсене Yandex или Google - devaka SEO блог

Много уебмастъри рано или късно ще се изправят пред необходимостта да се премахне от двигателя страници за търсене, които са преминали там по погрешка е престанало да бъде от значение са двойни или съдържат чувствителна информация с клиентите (причините могат да бъдат различни). Ярък пример за това вече сензационно ситуация MegaFon, SMS-и, които хората са индексирани Yandex, ситуацията с онлайн пазаруването, къде да намеря, че е възможно да се намерят личните данни на клиентите си и подробности за техните поръчки, ситуацията с банките и транспортни компании, и така нататък ...

няма да се справят с в тази статия, на причините за инцидента, описани по-горе, и да обмислят как да се премахне ненужната Yandex или Google страница. Изводът е, че те prenadlezhat сайта си, в противен случай е необходимо да се свържете със собственика на имота си с съответното искане.

5 начина за премахване на страници от резултатите от търсенето

1. Грешка 404

HTTP / 1.1 404 Not Found

В този случай, ще трябва да изчакате, докато роботът отново няма да дойде на тази страница. Понякога това отнема значително време, в зависимост от това как тя влезе в индекса.

Ако страницата, когато го извадите от търсенето трябва да съществува на сайта, този метод не е подходящ, по-добре е да използвате други представени по-долу.

2. Файлът robots.txt

Много популярен метод е да се затвори от индексиране на цели части или отделни страници е да се използва коренът на файла robots.txt. Има много ръководства, как да конфигурирате този файл. Тук представяме само няколко примера.

Затвори раздел администраторския панел от своя контакт с индекса на търсачките:

User-Agent: *

Disallow: / администратор /

Затворете определена страница индексиране:

User-Agent: *

Забрани: /my_emails.html # затваряне my_emails.html страница

Забрани: /search.php?q=* # заключителните страници на търсене

В случай на robots.txt също трябва да изчакаме за повторно индексиране, докато роботът няма да извадите от индексната страница или цял раздел. В същото време, някои от страниците може да остане в индекса, ако причината за тяхното получаване имаше няколко външни връзки.

Този метод е неудобно да се използва, ако е необходимо, отстранете различните страници на отделните секции, ако това е невъзможно да се изготви общ образец на директивата Disallow в robots.txt.

3. Мета-тагове роботи

Това е алтернатива на предишния метод, само правилото е зададено директно в HTML тага на страницата, между маркерите

.Лесен за мета тагове, които можете да добавите всички желани страници (от системата за контрол), което е нежелателно да влизат в индекса на търсачката, оставяйки файла robots.txt в същото време проста и ясна. Недостатък на този метод само с това, че е трудно да се приложи динамичен сайт с помощта на шаблон header.tpl, ако няма специални умения.

4. Заглавия X-роботи-Tag

Този метод се използва от чужди системи за търсене, включително Google, като алтернатива на предишния метод. В Yandex няма официална информация за подкрепата на HTTP-заглавието, но е възможно в близко бъдеще ще бъде.

Същността на неговата употреба е много подобен на роботи мета тагове, с изключение на това, че записът трябва да е в HTTP-хедърите, които не са видими в кода на страницата.

X-роботи-Tag: Noindex, Nofollow

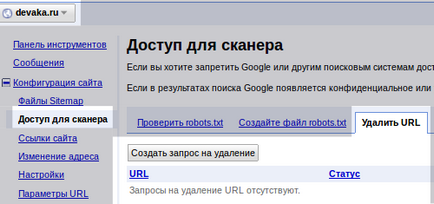

5. Ръчно отстраняване на уебмастера на панела

И накрая, последната и най-бързият начин за премахване на страници от индекса - това е тяхната ръчно преместване.

Единственото изискване за ръчното отстраняване на страници - те трябва да бъдат покрити от роботи предишните методи (в robots.txt, мета тагове, или грешка 404). Той е забелязал, че Google обработва исканията за отстраняване в рамките на няколко часа, Yandex трябва да чакам за следващата актуализация. Използвайте този метод, ако имате нужда от спешно да премахнете малък брой страници от търсенето.

Линкове към темата

5 съвета за създаване на практически страница 404

Подобряване на използваемостта на 404th страници намалява степента на отпадане. В статията се дава няколко съвета, за да ви помогне да направи 404-тата страница по-ефективна.

Цялата информация за robots.txt

За тези, които все още не са изправени пред конфигуриране на файла robots.txt, когато ресурсът ще бъде полезна отправна точка. Тя събира много примери и друга полезна информация.

Yandex: Използването на robots.txt

Официални примери използват файла robots.txt от Yandex. Също така, има са представени от Yandex отчетени насоки и други съвети.

Мета тагове Google уважава и Yandex изглежда да се съсредоточи не виждат. Само вчера забелязах, че търсене Yandex добавя два пъти повече страници, отколкото има на сайта. Оказа се, че е игнориран <Мета име = "роботи" съдържание = "Noindex, Nofollow" />,и ми таг облак имам в индекса.

Google казва (и моя малък опит потвърждава), че той просто не индексира в два случая:

1) Мета маркер

2) robots.txt + URL включване в списъка, за да се отстранят webmasters.google (Configuration -> Scanner достъп -> Изтриване URL)

А като отпътуваха много лесно. Google в рамките на няколко часа, но винаги пази история на адреса. Yandex ... едва след тази статия разбрах, защо е било невъзможно да се отстрани - трябва да се изчака няколко години, когато разбра какво трябва да направи.

И как ефективно затваряне страници от индексиране роботи за мета маркери, докато не се предписва като директива за забрана на файла robots.txt? В крайна сметка, ако ситуацията е обратна: в страницата файла robots.txt е затворен, а след това маркер мета роботи се игнорира от СС.

natkalin. Да, роботи това е само препоръка към търсачката, но не и инструкция да действа, като веднъж бе казал Mett Katts. Въпреки това, роботите ги следвайте внимателно, ако напротив има наложителна причина. За мета-таг, аз се заличава толкова страници в Яндекс. Имаше около 400, 5-7 актуализации е 58, от много дълго време, тъй като роботът не идва често на страниците, но мета маркера все още работи ...

WMAs. ако изтриете връзка към страница, търсачките не съобщават за грешка. Макар да, известно време няма да скучаете 🙂

Панел в Google за уеб администратори на страницата, се отстраняват един по един?) Ако, да речем, има сайт, в които са били планирани езикови версии в проектирането, които не са били преведени, а по-късно не е направил превода за тях. Оказва се, един куп страници дублаж)) може, разбира се, да ги затворят, като индексирането по-късно, но тези страници все още ще бъде в индекса е все още няколко месеца и презапис, тази страница не е желателно. Въпросът е, има ли възможност да се премахнат всички панелите на определен език версия на страницата, или все още трябва да изберете бавно на една страница?) Благодаря ви)

Позволете ми да се изясни. Може би някой ще ви помогне да спестите време. Ако имате директиви на robots.txt 2 "User-Agent: Yandex" и "User-Agent: ', Yandex търси само в частта им, без да обръща внимание на генерала. Ето защо, всички им Disallow: поставете секция за Yandex или изтриване на този раздел и да използвате директивата "за всички роботи. Правя преди да дойде, убит половин час 🙂

Prompt, неоправено сайт, който вече бе изпълнен с хостинга, чудото се намира в индекса, 145 страници, тези страници или празни или кривата на текста, или грабеж, но се изпълни с цел да се променят.

Как да бъде в тази ситуация? Трябва ли да се премахнат всички страници с индекс? Или, можете бързо да се определи главната страница? Преименуване на много страници, какво ще се случи със старите страници са индексирани? И всичко това на боклука в индекса, ще се отрази на рейтинга на бъдеща оптимизация?

Ще бъда много благодарен за ясен отговор!

Ако бях на твое място затворен за индексиране на сайта в robots.txt и да го премахнете напълно от индекса през панела за уебмастъри. След освобождаването на всички вече е отворено и индексиране ще отида отново.

Не санкции не трябва да бъде във всеки един от случаите, които сте избрали. И когато говорим за класиране, имаме предвид рейтинга на полезни документи, няма да бъдат показвани само боклук.

Да изтрия профила си от сайта, но моята лична информация, като например: име, дата на раждане, снимка все още вижда при търсене в Google. Възможно ли е в този случай, създаване на 404, ако не притежавате такъв? Трябва да се премахне информацията по някакъв начин, но не знам как. Вече съм отишъл в услуга на Google, който описах моя проблем. Те казаха, че е необходимо да се обърнете към сайта собственика / администратора. Изпратих много писма, но мълчанието.

Катрин, информацията, има функция за клониране, че чисти след това не винаги. Ако нямате достъп до тези, на които искате да изтриете информацията, че е малко вероятно имате нещо да работи, трябва да преговаря със собствениците. Или ако по някакъв начин нарушава закона, е да се напише жалба до хост. 404 на някой друг сайт, който може не само да направи своя администратор.

Петър, то вероятно е съвпадение. Някъде другаде прецаках. Проверка на robots.txt, мета-роботи и заглавията на HTTP.

проверени мета роботи - всичко е добро, HTTP хедъри - също са добри.

В действителност, когато те взеха на сайта, файла robots.txt не е директива Yandex. Имам го добавя за да се провери наличието на страници, всички го изпълняват правилно.

Възможно ли е: Yandex видя обновената Роботи и реши, така да се каже, да се започне от нулата?